| Input | I strato | II strato

|

|

|

||

|

|

||

|

|

| Input | I Strato | II Strato

|

|

|

||

|

|

||

|

|

|

|

|

|

|

|

|

0 | ||

|

|

1 | ||

|

|

1 | ||

|

|

0 |

| Input | I strato | II strato

|

|

|

||

|

|

|

|

|

|

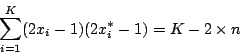

Iniziamo dimostrando che![$G\left[x^{*};x\right]=1\quad\Leftarrow\quad x=x^{*}$](img232.png)

![\begin{displaymath}

G\left[x;x\right]=\theta\left[\sum^{K}_{i=1}(2x_{i}-1)^{2}-K+1\right]=\theta\left[\sum^{K}_{i=1}1-K+1\right]=1

\end{displaymath}](img233.png)

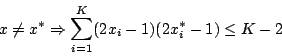

Quindi mostriamo com:

Per cui:

doveè il numero degli indici

tali che

, da cui segue:

La dimostrazione è completata.Fissato

![\begin{displaymath}

G\left[x^{*};x\right]=\theta\left[2\sum^{K}_{i=1}(2x^{*}_{i}-1)x_{i}-2\sum^{K}_{i=1}x^{*}+1\right]

\end{displaymath}](img244.png)

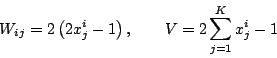

![\begin{displaymath}

y_{i}=\theta\left[\sum^{K}_{j=1}W_{ij}x_{j}-V\right] \qquad

S(y)=\theta\left[\sum^{L}_{i=1}y_{i}-\frac{1}{2}\right]

\end{displaymath}](img249.png)

Tutte le operazioniDato che la cardinalità dipossono essere realizzate da una rete a due strati di tipo feed-forward, con neuroni di McCulloch-Pitts.