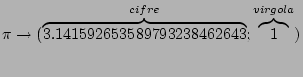

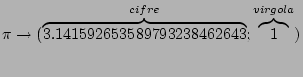

Ogni tale rappresentazione finita (numeri a precisione finita) può essere rappresentato da un numero finito di interi:

Ogni intero, infine, si può esprimere come una stringa di numeri binari

| x y | x |

| 0 0 | 0 |

| 0 1 | 0 |

| 1 0 | 0 |

| 1 1 | 1 |

| x y | x |

| 0 0 | 0 |

| 0 1 | 1 |

| 1 0 | 1 |

| 1 1 | 1 |

| x | |

| 0 | 0 |

| 1 | 1 |

|

|

|

||||

| 0 | 0 | 0 | 1 | 1 | 1 |

| 0 | 1 | 1 | 1 | 0 | 0 |

| 1 | 0 | 1 | 0 | 1 | 0 |

| 1 | 1 | 1 | 0 | 0 | 0 |

|

|

|

||

| 0 | 0 | 1 | 0 |

| 0 | 1 | 1 | 0 |

| 1 | 0 | 1 | 0 |

| 1 | 1 | 0 | 1 |

|

|

|

| 0 | 1 |

| 1 | 0 |

![\begin{displaymath}

S_{i}(t+\Delta )=\theta \left[ \sum ^{N}_{k=1}J_{ik}S_{k}(t)-U_{i}^{*}\right] \end{displaymath}](img49.png)

![\begin{displaymath}

S(t+\Delta )=\theta \left[ \sum

^{2}_{k=1}J_{k}S_{k}(t)-U^{*}\right]=\theta

\left[J_{1}x+J_{2}y-U^{*}\right]\end{displaymath}](img120.png)

|

|

|

|||

| 0 | 0 | 0 | -3/2 | 0 |

| 0 | 1 | 0 | -1/2 | 0 |

| 1 | 0 | 0 | -1/2 | 0 |

| 1 | 1 | 1 | 1/2 | 1 |

|

|

|

|||

| 0 | 0 | 0 | -1/2 | 0 |

| 0 | 1 | 1 | 1/2 | 1 |

| 1 | 0 | 1 | 1/2 | 1 |

| 1 | 1 | 1 | 3/2 | 1 |

|

|

|

||

| 0 | 1 | 1/2 | 1 |

| 1 | 0 | -1/2 | 0 |

|

|

|

|||

| 0 | 0 | 1 | 3/2 | 1 |

| 0 | 1 | 1 | 1/2 | 1 |

| 1 | 0 | 1 | 1/2 | 1 |

| 1 | 1 | 0 | -1/2 | 0 |